Au cours des dernières années, l’IA est en plein essor et les leaders technologiques ont trouvé des moyens d’intégrer l’IA dans divers secteurs commerciaux et industriels. L’une de ces intégrations réussies de l’IA a été dans le domaine de la génération d’images intuitives. Open AI, une société d’intelligence artificielle populaire a développé et lancé ce que l’on appelle des générateurs de texte en image sous le nom DALL-E 2 il y a quelque temps, et récemment, la société a publié une version plus récente de la génération d’images AI et l’a baptisée DALL-E 2.

Nous sommes ici pour vous expliquer tout ce qu’il y a à savoir sur DALL-E 2 dans ce blog. En fait, ce blog servira de guide pour DALL-E 2, donc avant de pouvoir continuer, je vous invite à mettre le blog en signet pour une utilisation ultérieure.

Qu’est-ce que DALL-E 2 ?

Grâce à l’utilisation d’invites texte-graphique, les utilisateurs peuvent générer de nouvelles images à l’aide de la technologie d’IA générative DALL-E 2. Fonctionnellement, DALL-E 2 est un réseau de neurones capable de créer des graphiques complètement originaux dans une variété de styles différents en réponse aux instructions de l’utilisateur.

Le nom DALL-E 2 fait référence aux deux idées clés distinctes de la technologie et fait allusion à l’intention de fusionner l’art et l’intelligence artificielle. Alors que la deuxième partie (E) est connectée au robot Disney maquillé Wall-E, la première partie (DALL) est destinée à invoquer la mémoire du célèbre surréaliste espagnol Salvador Dali.

La combinaison des deux titres traduit la capacité de la technologie à illustrer des idées de manière abstraite et parfois surréaliste et est mécanisée par une machine.

DALL-E 2 a été créé par le fournisseur de services d’IA OpenAI et a fait ses débuts en janvier 2021. Le système utilise des modèles d’apprentissage en profondeur en conjonction avec le grand modèle de langage GPT-3 comme base pour comprendre les demandes des utilisateurs en langage naturel et produire de nouveaux visuels.

DALL-E 2 est une amélioration de Image GPT, une idée qu’OpenAI a mentionnée pour la première fois en juin 2020 et qui était une première tentative pour montrer comment un réseau de neurones peut être utilisé pour produire de nouvelles photos de haute qualité. Avec l’aide de DALL-E 2, OpenAI a pu étendre l’idée originale d’Image GPT et fournir aux utilisateurs la possibilité de créer de nouvelles images en réaction aux invites de texte, tout comme GPT-3 peut créer un nouveau texte en réponse aux invites de texte dans langage naturel.

La technologie DALL-E 2 est en concurrence avec d’autres technologies connexes telles que Stable Diffusion et Midjourney et relève d’un sous-domaine de l’IA fréquemment appelé conception générative.

Architecture technologique de DALL-E 2

On dit que DALL-E 2 utilise l’approche de modélisation multimodale pour générer des images à partir d’entrées de texte. Examinons donc de plus près la technologie derrière DALL-E 2.

Modélisation multimodale

Les modèles multimodaux sont ceux qui peuvent gérer une variété de types de données différents. Cela peut s’appliquer à l’entrée, à la sortie ou aux deux. DALL-E est un exemple bien connu de génération de texte en image dans lequel nous saisissons une description textuelle et cherchons à produire une image qui correspond à la description.

Comment construire un pont entre les différents modes d’utilisation des données est un défi important dans le contexte de la modélisation multimodale. En ce qui concerne DALL-E, cela impliquerait de connecter la représentation textuelle à une représentation d’image qui comprend le sens des mots, peut-être à travers des incorporations de mots, puis transforme ces incorporations de mots significatifs en objets dans des images véhiculant le même sens.

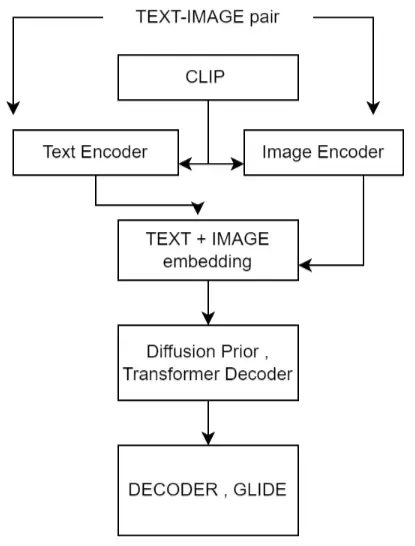

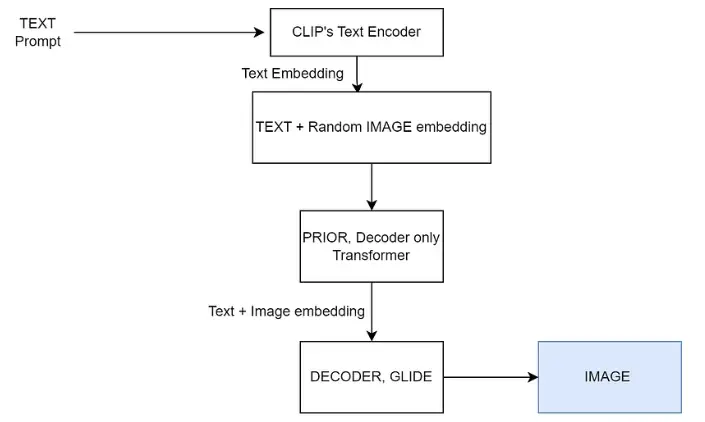

Comme on le voit dans les illustrations ci-dessus, l’architecture finale pour la génération d’images et l’ensemble des modèles utilisés pour entraîner DALL-E 2 sont tous deux visibles.

Comment fonctionne DALL-E 2 ?

Le traitement du langage naturel (NLP), les grands modèles de langage (LLM) et le traitement de diffusion sont quelques-unes des technologies employées par Dall-E.

Une partie du GPT-3 LLM a été utilisée dans la construction de DALL-E 2. Dans une approche qui a été créée pour être optimisée pour la production d’images, DALL-E 2 n’utilise que 12 milliards de paramètres par opposition à l’ensemble des 175 milliards de paramètres qui Offres GPT-3. DALL-E 2 utilise un réseau neuronal de transformateur, communément appelé transformateur, pour aider le modèle à construire et à comprendre les connexions entre plusieurs concepts, un peu comme le GPT-3 LLM.

Techniquement parlant, la méthode qui rend DALL-E 2 possible a été décrite pour la première fois par les chercheurs d’Open AI sous le nom de Zero-Shot Text-to-Image Generation et discutée dans un document de recherche de 20 pages publié en février 2021. Zero-Shot est une stratégie d’IA où un modèle peut effectuer une tâche, comme créer une image complètement nouvelle, en s’appuyant sur les connaissances antérieures et les concepts associés.

Open AI a également développé le modèle CLIP (Contrastive Language-Image Pre-training), qui a été formé sur 400 millions d’images étiquetées, pour soutenir l’affirmation selon laquelle le modèle Dall-E était capable de générer avec précision des images. En déterminant quelle légende convient le mieux à une image créée, CLIP a été utilisé par OpenAI pour évaluer la sortie de DALL-E 2.

Une méthode connue sous le nom d’auto-encodeur variationnel discret (dVAE), qui était en partie basée sur des recherches effectuées par la division DeepMind d’Alphabet avec l’auto-encodeur variationnel quantifié vectoriel, a été utilisée dans l’itération initiale de Dall-E (Dall-E 1) pour produire images à partir du texte.

Afin de produire des images plus sophistiquées et photoréalistes, DALL-E 2 a développé les techniques employées pour son prédécesseur. Afin de produire une image de meilleure qualité, DALL-E 2 utilise un modèle de diffusion qui intègre les données du modèle CLIP.

Cas d’utilisation de DALL-E 2

DALL-E 2 peut être utilisé de diverses manières pour aider les personnes et les organisations car il s’agit d’une technologie d’IA générative, notamment :

Conceptions créatives

Une personne créative peut être encouragée à proposer quelque chose de nouveau en utilisant la technologie. En complément d’un processus de création déjà existant, c’est aussi une option.

Industrie du divertissement

Les œuvres d’art de Dall-E pourraient être incorporées dans des livres ou des jeux vidéo. Parce que le système d’invite est plus simple à utiliser pour produire des images, DALL-E 2 peut aller au-delà de ce qui est possible avec l’imagerie générée par ordinateur (CGI) conventionnelle.

Conceptions de produits

Cet outil incroyable permet aux concepteurs de produits de visualiser rapidement de nouvelles idées en utilisant uniquement du texte, par opposition à l’utilisation plus longue des outils de conception assistée par ordinateur (CAO) typiques.

Avantages de DALL-E 2

Vitesse accrue

DALL-E 2 peut générer une image à partir d’une brève invite de texte en quelques secondes, souvent moins d’une minute.

Personnalisation à part entière

Un utilisateur peut produire une image très personnalisée de presque tout ce à quoi il peut penser sur la base d’une invite de texte.

Plus d’accessibilité

DALL-E 2 est relativement facile à utiliser pour les utilisateurs car il ne nécessite que du texte en langage naturel et ne nécessite aucune connaissance particulière en programmation ou une formation considérable.

Extensibilité

Cela peut aider quelqu’un à développer une image existante en la remixant ou en lui permettant de la réimaginer d’une manière différente.

Limites de DALL-E 2

Problème de copyright

On ne sait toujours pas si DALL-E 2 a été formé sur des photographies protégées par le droit d’auteur et combien de droits d’auteur il y a sur les graphiques qu’il a créés.

Base de données

Même si DALL-E 2 a été formé sur une quantité importante de données, il y a encore énormément de données accessibles pour les photos et les descriptions. Par conséquent, étant donné que le modèle ne contient pas les données nécessaires, une invite utilisateur peut ne pas produire l’image souhaitée.

Réalisme des images

Même si la qualité d’image des photos générées a considérablement augmenté grâce à DALL-E 2, certaines photos peuvent encore avoir une qualité qui ne les rend pas suffisamment réalistes pour certaines personnes.

Contexte

L’utilisateur doit avoir une invite clairement définie afin de recevoir l’image correcte. L’image produite par DALL-E 2 peut être erronée si la requête est très générale et dénuée de tout contexte.

La différence entre DALL E et DALL-E 2

Les utilisateurs bénéficient d’un certain nombre de fonctionnalités améliorées grâce au moteur DALL-E 2, qui est une évolution du moteur Dall-E d’origine.

DALL-E ou DALL-E 1 et DALL-E 2 sont sortis respectivement en janvier 2021 et avril 2022. Les images ont été produites par un dVAE avec le Dall-E original d’OpenAI. Un modèle de diffusion générateur d’images est utilisé par DALL-E 2. Selon OpenAI, les photographies produites avec DALL-E 2 peuvent avoir une résolution quatre fois supérieure. Un autre avantage de DALL-E 2 par rapport à son prédécesseur est une augmentation de la vitesse et de la capacité de taille d’image, ce qui permet aux clients de produire plus rapidement des photos plus grandes.

Avec le modèle DALL-E 2, la gamme de styles disponibles pour la personnalisation des images a également été considérablement élargie. Une image peut être dessinée en pixel art ou en peinture à l’huile, par exemple, selon un stimulus. L’idée d’outpainting a également été introduite dans DALL-E 2 et permet aux utilisateurs de produire une image comme une extension (ou outpainting) d’une image originale.

Combien coûte l’utilisation de DALL-E 2 ?

L’entreprise a développé un système de crédit pour aider à mesurer l’utilisation des personnes qui utilisent DALL-E 2 directement sur le site Web OpenAI. Les premiers utilisateurs de DALL-E 2 qui se sont inscrits avant le 6 avril 2023 reçoivent actuellement des crédits gratuits. Ces crédits sans frais sont renouvelés mensuellement et s’épuisent un mois après leur émission. Chaque fois qu’une demande est faite pour générer ou modifier une image à l’aide de DALL-E 2, le crédit est utilisé. Les crédits peuvent être achetés par les nouveaux utilisateurs. En avril 2023, le prix de 115 crédits est de 15 $. Un an après l’achat, les crédits achetés expirent.

OpenAI facture les développeurs qui utilisent l’API sur la base du coût par image. Le prix dépend de la taille de la photographie. Une image 256 × 256 coûtait 0,016 $, une image 512 × 512 coûtait 0,018 $ et une image 1024 x 1024 coûtait 0,020 $ en avril 2023.

Conclusion

DALL-E 2 ne vous fournira probablement pas les résultats que vous désirez tout de suite. L’écriture de nouvelles invites pour des éléments particuliers dans les images peut être nécessaire pour les modifier. Cela dit, il s’agit d’un outil fantastique qui peut vous aider à optimiser votre site Web ainsi que l’ensemble de votre organisation.