Lorsque vous créez un blog ou un site Web sur WordPress, un fichier robots.txt est automatiquement créé pour chacune de vos pages de destination et articles. Il s’agit d’un aspect important du référencement de votre site Web, car il sera utilisé par les moteurs de recherche lors de l’exploration du contenu de votre site.

Si vous souhaitez faire passer le référencement de votre site Web au niveau supérieur, l’optimisation du fichier robots.txt sur votre site WordPress est importante mais, malheureusement, pas aussi simple que d’ajouter des mots-clés à votre contenu. C’est pourquoi nous avons élaboré ce guide sur WordPress robots.txt afin que vous puissiez commencer à le perfectionner et à améliorer votre classement dans les recherches.

Qu’est-ce qu’un fichier Robots.txt ?

Lorsque vous placez des sites Web sur les pages de résultats des moteurs de recherche (SERP), les moteurs de recherche tels que Google « explorent » les pages de sites Web et analysent leur contenu. Le fichier robots.txt de n’importe quel site Web indique au robot d’exploration quelles pages explorer et lesquelles ne pas explorer – essentiellement une forme de Automatisation des processus robotiques (RPA).

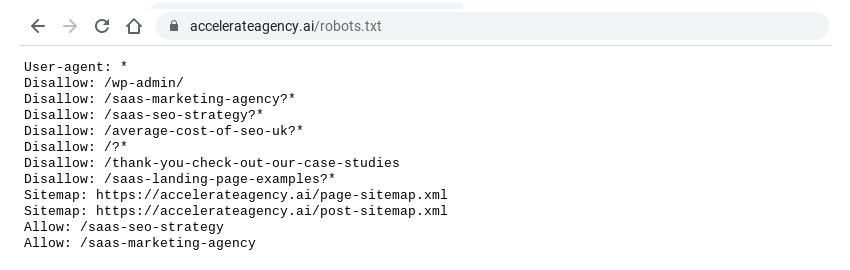

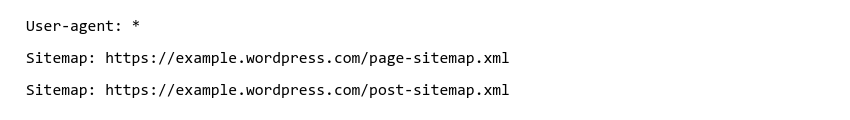

Vous pouvez voir le fichier robots.txt de n’importe quel site Web en tapant /robots.txt après le nom de domaine. Cela ressemblera à quelque chose comme ceci :

Décomposons chacun des éléments de l’image ci-dessus.

Agent utilisateur

L’agent utilisateur dans un fichier robots.txt est le moteur de recherche par lequel le fichier robots.txt doit être lu. Dans l’exemple ci-dessus, l’agent utilisateur est marqué d’un astérisque, ce qui signifie qu’il s’applique à tous les moteurs de recherche.

La plupart des sites Web acceptent que tous les moteurs de recherche explorent leur site, mais parfois, vous souhaiterez peut-être empêcher tous les moteurs de recherche, à l’exception de Google, d’explorer votre site ou fournir des instructions spécifiques sur la façon dont les moteurs de recherche tels que Google News ou Google Images explorent votre site Web.

Si tel est le cas, vous devez connaître l’ID d’agent utilisateur des moteurs de recherche que vous souhaitez instruire. C’est assez simple à trouver en ligne, mais voici quelques-uns des principaux :

- Google : Googlebot

- Google Actualités : Googlebot-Actualités

- Google Images : Googlebot-Image

- Vidéo Google : Googlebot-Vidéo

- Bing : Bingbot

- Yahoo : Bot Slurp

Autoriser et interdire

Dans les fichiers robots.txt, autoriser et interdire indique aux robots les pages et le contenu qu’ils peuvent et ne peuvent pas explorer. Si, comme mentionné ci-dessus, vous souhaitez empêcher tous les moteurs de recherche, à l’exception de Google, d’explorer votre site Web, vous pouvez utiliser le fichier robots.txt suivant :

La barre oblique (/) après « Interdire » et « Autoriser » indique au bot qu’il est autorisé ou non à explorer toutes les pages. Vous pouvez également mettre des pages spécifiques entre les barres obliques pour autoriser ou interdire au bot de les explorer.

Plan du site

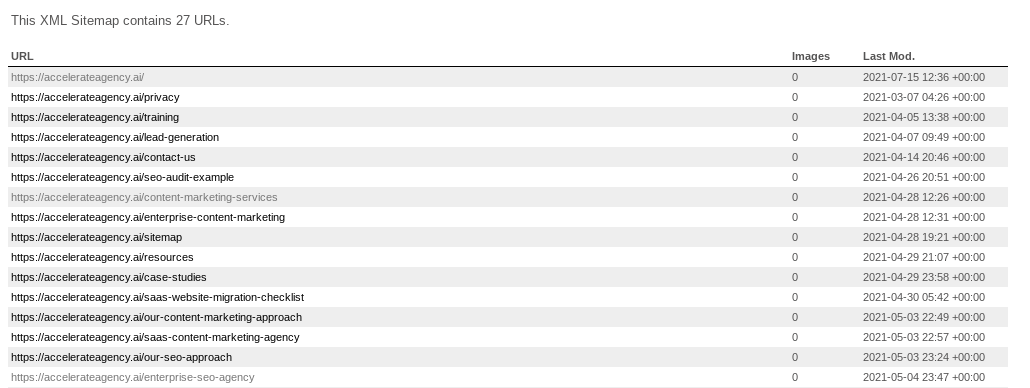

Le « plan du site » dans un fichier robots.txt est un fichier XML qui contient une liste et les détails de toutes les pages de votre site Web. Cela ressemble à ceci :

Le plan du site contient toutes les pages Web que vous souhaitez que le bot découvre. Le plan du site est particulièrement utile si vous avez des pages Web que vous souhaitez voir apparaître dans les résultats de recherche, mais qu’il ne s’agit pas de pages de destination typiques, telles que des articles de blog.

Les plans de site sont particulièrement importants pour les utilisateurs de WordPress qui espèrent revigorer leur site Web avec des articles de blog et des pages de catégorie. Beaucoup d’entre eux peuvent ne pas apparaître dans les SERP s’ils n’ont pas leur propre plan de site robots.txt.

Ce sont les aspects essentiels d’un fichier robots.txt. Il convient toutefois de noter que votre fichier robots.txt n’est pas un moyen infaillible pour empêcher les robots des moteurs de recherche d’explorer certaines pages. Par exemple, si un autre site utilise textes d’ancrage pour créer un lien vers une page que vous avez « interdite » dans votre fichier robots.txt, les robots des moteurs de recherche pourront toujours explorer cette page.

Avez-vous besoin d’un fichier Robots.txt sur WordPress ?

Si vous avez un site Web ou un blog propulsé par WordPress, vous aurez déjà un fichier robots.txt généré automatiquement. Voici quelques raisons pour lesquelles il est important de considérer votre fichier robots.txt si vous voulez vous assurer d’avoir un site WordPress convivial pour le référencement.

Vous pouvez optimiser votre budget de crawl

Un budget d’exploration, ou quota d’exploration, est le nombre de pages que les robots des moteurs de recherche exploreront sur votre site Web un jour donné. Si vous n’avez pas de fichier robots.txt optimisé, vous pourriez gaspiller votre budget d’exploration et empêcher les robots d’explorer les pages de votre site que vous souhaitez voir apparaître en premier dans les SERP.

Si vous vendez des produits ou des services via votre site WordPress, idéalement vous voulez les pages avec le meilleur conversion des ventes être prioritaire par les robots d’exploration.

Vous pouvez hiérarchiser vos pages de destination importantes

En optimisant votre fichier robots.txt, vous pouvez vous assurer que les pages de destination que vous souhaitez voir apparaître en premier dans les SERP sont faciles et rapides à trouver pour les robots d’exploration. Diviser l’index de votre site en un index « pages » et « articles » est particulièrement utile pour cela, car vous pouvez vous assurer que les articles de blog apparaissent dans les SERP plutôt que dans vos pages de destination standard.

Par exemple, si votre site Web contient beaucoup de pages et que votre données client montre que vos articles de blog génèrent beaucoup d’achats, vous pouvez utiliser des plans de site dans votre fichier robots.txt pour vous assurer que vos articles de blog apparaissent sur les SERP.

Vous pouvez améliorer la qualité globale du référencement de votre site Web

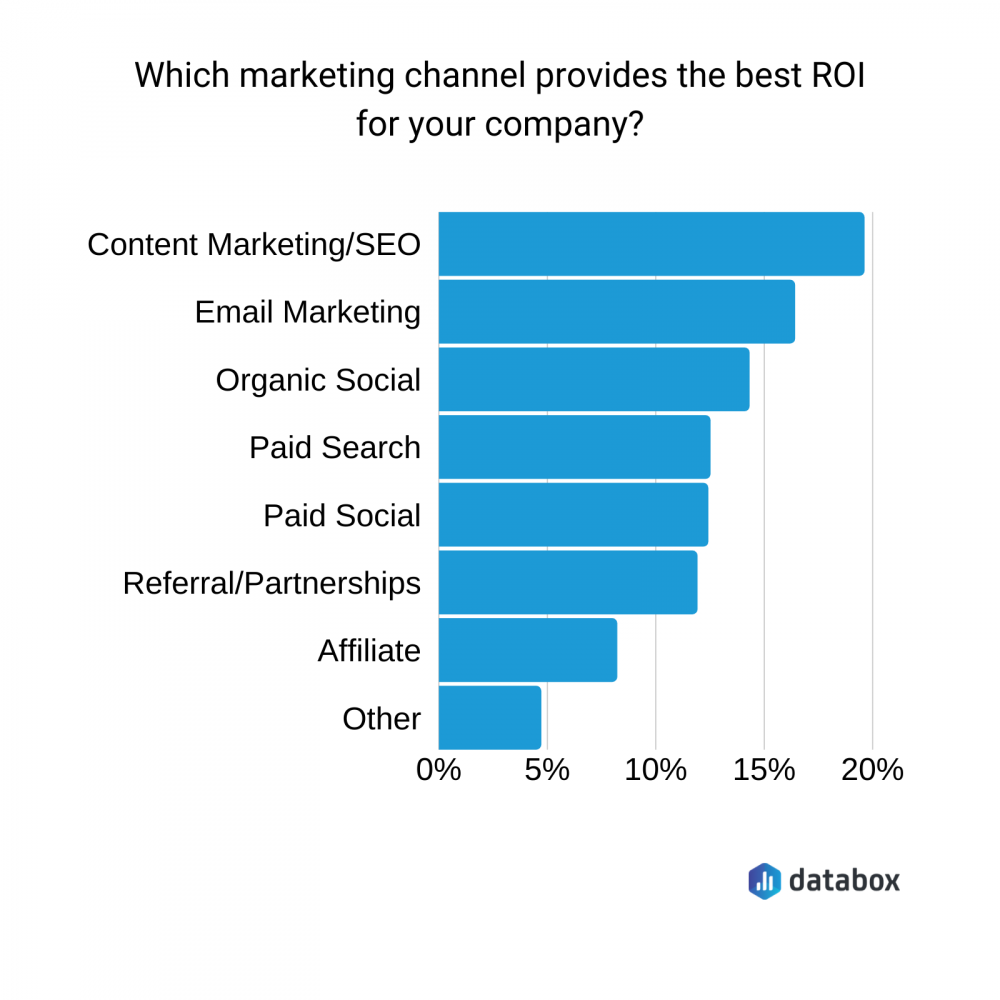

Les spécialistes du marketing sont bien conscients de la grande optimisation des moteurs de recherche ROI. Canaliser les recherches organiques vers votre site Web en se concentrant sur son référencement est moins cher et souvent plus efficace que les publicités payantes et les liens d’affiliation, bien que les deux soient toujours utiles. Consultez ces statistiques pour retour sur investissement du canal de commercialisation.

L’optimisation de votre fichier robots.txt n’est pas le seul moyen d’améliorer le classement de recherche de votre site Web ou de votre blog. Vous aurez toujours besoin d’un contenu optimisé pour le référencement sur les pages elles-mêmes, ce dont vous aurez peut-être besoin d’un Référencement SaaS fournisseur pour vous aider. Cependant, la modification de votre fichier robots.txt est quelque chose que vous pouvez facilement faire vous-même.

Comment éditer un fichier Robots.txt sur WordPress

Si vous souhaitez modifier votre fichier robots.txt sur WordPress, il existe plusieurs manières de le faire. L’option la meilleure et la plus simple consiste à ajouter un plugin à votre système de gestion de contenu – votre tableau de bord WordPress.

Ajoutez un plugin SEO à votre WordPress

C’est le moyen le plus simple de modifier votre fichier robots.txt WordPress. Il existe de nombreux bons plugins de référencement qui vous permettront de modifier le fichier robots.txt. Certains des plus populaires sont Yoast, Rank Math et All In One SEO.

Ajoutez un plugin Robots.txt à votre WordPress

Il existe également des plugins WordPress spécialement conçus en éditant votre fichier robots.txt. Les plugins robots.txt populaires sont Virtual Robots.txt, WordPress Robots.txt Optimization et Robots.txt Editor.

Comment tester votre fichier WordPress Robots.txt

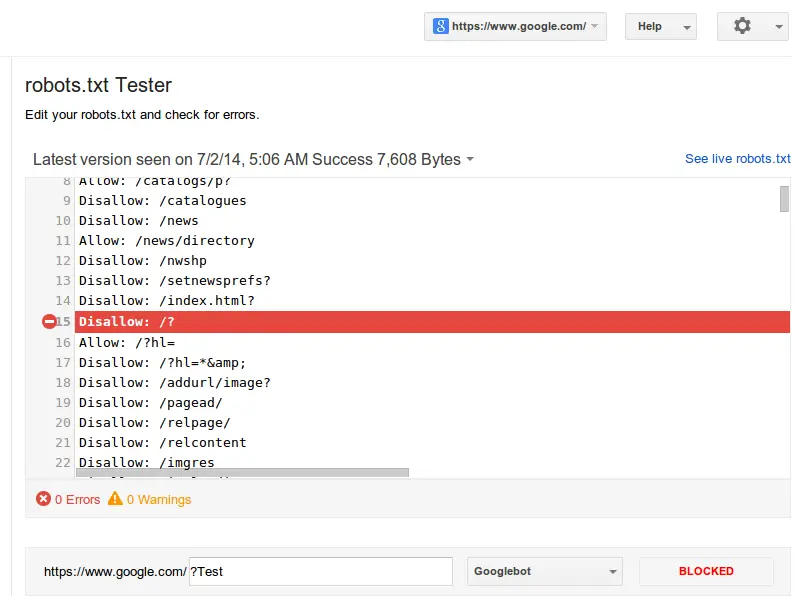

Si vous avez modifié votre fichier robots.txt, il est important de le tester pour vous assurer que vous n’avez commis aucune erreur. Des erreurs sur votre fichier robots.txt pourraient entraîner l’exclusion totale de votre site Web des SERP.

Google Webmaster a un outil de test robots.txt que vous pouvez utiliser gratuitement pour tester votre fichier. Pour l’utiliser, il vous suffit d’ajouter l’URL de votre page d’accueil. Le fichier robots.txt apparaîtra et vous verrez « avertissement de syntaxe » et « erreur de logique » sur toutes les lignes du fichier qui ne fonctionnent pas.

Vous pouvez ensuite entrer une page spécifique de votre site Web et sélectionner un agent utilisateur pour exécuter un test qui montrera si cette page est « acceptée » ou « bloquée ». Vous pouvez modifier votre fichier robots.txt sur l’outil de test et relancer le test si nécessaire, mais notez que cela ne changera pas votre fichier réel, vous devrez copier et coller les informations modifiées dans votre éditeur robots.txt et enregistrez-le là-bas.

Comment optimiser votre fichier WordPress Robots.txt pour le référencement

Le moyen le plus simple d’optimiser votre fichier robots.txt consiste à sélectionner les pages que vous souhaitez interdire. Sur WordPress, les pages typiques que vous pourriez interdire sont /wp-admin/, /wp-content/plugins/, /readme.html, /retracer/.

Par exemple, un commercialisation en mode SaaS fournisseur a beaucoup de pages et de publications différentes sur son site WordPress. En interdisant les pages comme /wp-admin/ et /wp-content/plugins/, ils peuvent s’assurer que les pages qu’ils apprécient sont priorisées par les robots d’exploration.

Créez des plans de site et ajoutez-les à votre fichier Robots.txt

WordPress crée son propre plan de site générique lorsque vous créez un blog ou un site Web avec. Cela peut généralement être trouvé à example.wordpress.com/sitemap.xml. Si vous souhaitez personnaliser votre plan de site et créer des plans de site supplémentaires, vous devez utiliser un plugin robots.txt ou SEO WordPress.

Vous pouvez accéder à votre plugin sur votre tableau de bord WordPress et il devrait avoir une section pour activer et modifier votre plan de site. De bons plugins vous permettront de créer et de personnaliser facilement des plans de site supplémentaires, tels qu’un plan de site « pages » et un plan de site « posts ».

Lorsque vos sitemaps sont configurés, ajoutez-les simplement à votre fichier robots.txt comme ceci :

Adoptez une approche minimaliste

Bien qu’il puisse être passionnant d’éditer et d’optimiser votre fichier robots.txt WordPress, il est important d’avoir une approche minimaliste, moins c’est plus. En effet, si vous interdisez les pages de votre site, cela empêchera les robots d’exploration de rechercher d’autres pages dans ces pages. Cela pourrait signifier que les pages clés ne sont pas découvertes et que l’intégrité structurelle de votre site est affaiblie du point de vue des robots des moteurs de recherche.

Il n’est pas non plus nécessaire d’« autoriser » l’accès à chaque page de votre site Web dans le fichier robots.txt. Les robots d’exploration découvriront déjà ces pages – concentrez-vous plutôt sur vos plans de site et les pages que vous devez interdire afin que vos pages clés soient trouvées en premier.

Dans ce guide, nous avons fourni tout ce que vous devez savoir sur les fichiers robots.txt de WordPress. Qu’il s’agisse d’expliquer ce que sont les fichiers robots.txt ou de découvrir pourquoi et comment optimiser votre fichier robots.txt pour le référencement, cet article vous aidera si vous souhaitez trouver des moyens simples et efficaces d’améliorer le classement de recherche de votre site Web WordPress.